Hervé Dole est professeur à l’Université Paris-Saclay, à l’Institut d’astrophysique spatiale. Dans son livre « Le côté obscur de l’univers » sorti aux Éditions Dunod, il nous emmène à la découverte des recherches récentes en cosmologie, entre les enseignements de la mission spatiale européenne Planck et les quêtes de la future mission Euclid, dont le lancement est prévu pour 2022.

Après Planck dans les années 2010, Euclid sera la mission spatiale majeure de la décennie 2020 en cosmologie. Ce satellite européen – avec une dominante française en termes de contributions scientifique et technique – aura pour but de démasquer comme jamais auparavant le comportement de la matière noire et de l’énergie sombre. En route pour le futur !

Y voir clair dans le secteur sombre de l’univers

Euclid sera la seconde mission spatiale européenne à visée cosmologique et, comme avec Planck, le poids de la communauté scientifique française s’avère déterminant. Depuis plusieurs années déjà, les chercheurs et ingénieurs des organismes de recherche nationaux (CNRS et CEA), des universités et de leurs laboratoires, avec le soutien de l’agence spatiale française (CNES), se démènent pour concevoir et tester cette extraordinaire machine, avant son lancement prévu à l’horizon 2022.

Le principal but d’Euclid sera de comprendre le « secteur sombre » de l’univers, à savoir la matière noire et l’énergie sombre. Il va donc s’attaquer aux deux problématiques phares de la cosmologie contemporaine. Ses deux principales sondes cosmologiques (les deux types de mesures qu’il effectuera) seront le lentillage gravitationnel faible (ou weak lensing) et l’agrégation des galaxies (ou clustering).

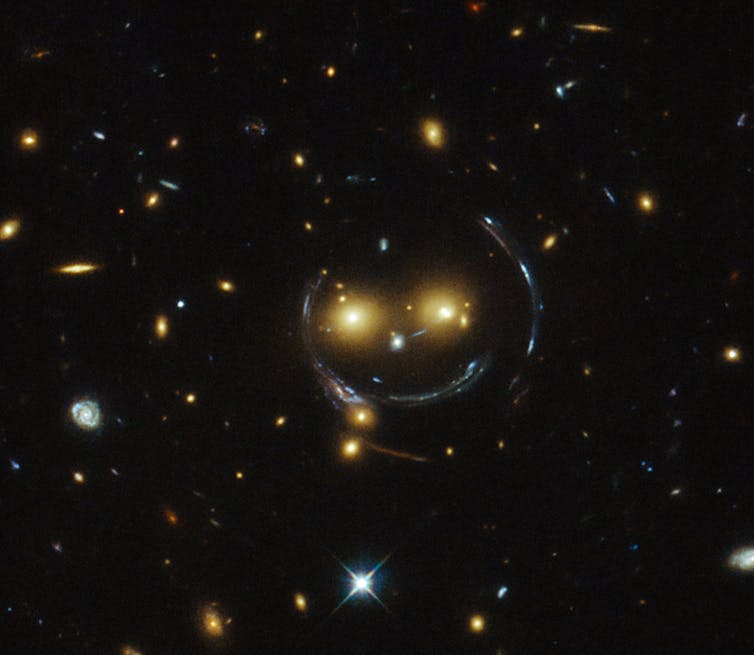

Tracer la matière noire par lentillage gravitationnel

Le lentillage faible permet de mesurer précisément la quantité et la distribution de matière noire, et de reconstituer finement l’évolution de la formation des structures selon la distance cosmologique, ou l’époque cosmique, mesurée par le redshift (décalage spectral cosmologique vers le rouge), afin de déceler les effets de l’énergie sombre.

Pour effectuer de telles mesures, Euclid prendra des milliers d’images ultra-précises du ciel en lumière visible, qui permettront de mesurer les formes et les orientations des galaxies. En ne considérant qu’une seule galaxie ou un petit nombre d’entre elles, leurs orientations sont presque entièrement aléatoires. Mais s’il existe une grande quantité de matière noire entre ces galaxies lointaines et nous, leur orientation collective est affectée… et Euclid pourra le détecter ! Cet effet de lentillage gravitationnel faible permet de tracer sur les images des sortes de lignes, indiquant les changements d’orientation des galaxies d’arrière-plan. Ces lignes sont directement reliées à la « masse déflectrice » (celle de la matière noire) que l’on peut alors mesurer précisément.

Cette technique – qui existe depuis des années – avait été évoquée en détail dans le chapitre 7 du livre. Euclid va introduire une première grande nouveauté : l’ampleur et la précision des mesures effectuées, grâce à une image géante couvrant quasiment la totalité du ciel.

Deuxième grande nouveauté : nous disposerons d’images en infrarouge proche, qui faciliteront énormément l’estimation de la distance cosmologique des galaxies (donnée par leur redshift). Nous pourrons ainsi sélectionner des galaxies de plus en plus lointaines, et mesurer la quantité de matière noire en fonction de la distance (donc de l’époque cosmique).

Révéler l’énergie sombre grâce au clustering

Deuxième sonde cosmologique : l’agrégation des galaxies (ou clustering). Le principe consiste à mesurer les distances entre galaxies sur de grands volumes, afin de calculer une sorte de « distance moyenne entre galaxies ». Du point de vue mathématique, on calcule une « fonction de corrélation à deux points » qui représente, pour une distance donnée, l’excès de galaxies par rapport à une distribution aléatoire dans l’espace. La fonction de corrélation mesure ainsi le degré d’agrégation des galaxies ; on peut ensuite la comparer aux prédictions du modèle cosmologique.

En 2005, deux équipes de chercheurs ont découvert une échelle particulière de corrélation entre galaxies, qui n’est détectable qu’en observant l’univers à grande échelle (environ 200 Mpc, soit plusieurs centaines de millions d’années-lumière). Elle est associée aux oscillations baryoniques acoustiques (BAO), qui traduisent au fond « l’appétence » des galaxies à se distribuer dans l’espace selon une échelle privilégiée. Celle-ci est due aux modes de vibration du plasma primordial, que l’on observe dans les « pics acoustiques » des fluctuations du fond cosmologique.

Euclid détectera les BAO avec une précision remarquable, et il pourra même les mesurer sur un volume correspondant aux 8 derniers milliards d’années de l’Univers ! Comme vu précédemment dans le livre, ces BAO constituent une sonde importante pour caractériser précisément l’équation d’état de l’énergie sombre (la relation entre sa densité et sa pression).

De nombreuses autres mesures seront effectuées (statistiques d’ordre supérieur notamment, mais aussi utilisation des amas de galaxies) en vue de mieux contraindre le modèle cosmologique ainsi que les lois de la gravitation et l’évolution des galaxies.

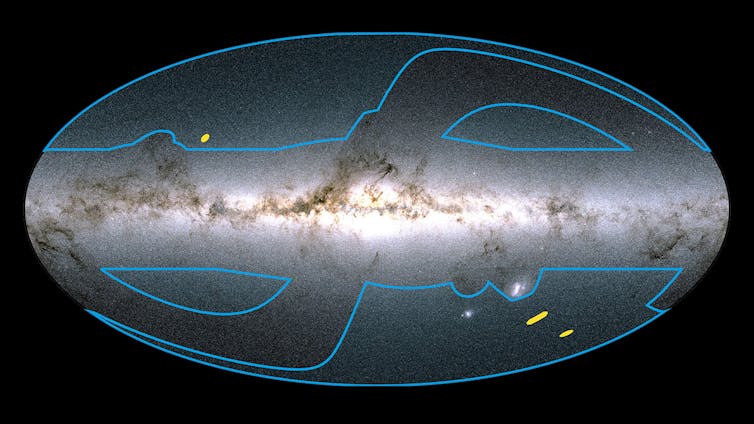

Une majestueuse image de la voûte céleste

Afin d’utiliser ces deux sondes cosmologiques, Euclid effectuera un gigantesque relevé de galaxies, couvrant rien de moins que la moitié du ciel avec une impressionnante qualité d’image. Il s’agira en réalité de la quasi-totalité du ciel dit « extragalactique », l’autre moitié de la voûte étant déjà « contaminée » par notre Voie lactée… Imaginez une qualité comparable à celle du télescope spatial Hubble, sur des images qui ne couvriront pas de « petits champs » visuels, mais quasiment tout le ciel profond observable ! Une vraie révolution.

Durant ses cinq à six années d’opération, Euclid devrait ainsi détecter, dans les domaines du visible et du proche infrarouge, des milliards de galaxies jusqu’à un redshift d’environ 2, et des milliers d’autres à des redshifts compris entre 2 et 8.

Des caméras extraordinaires… et des défis !

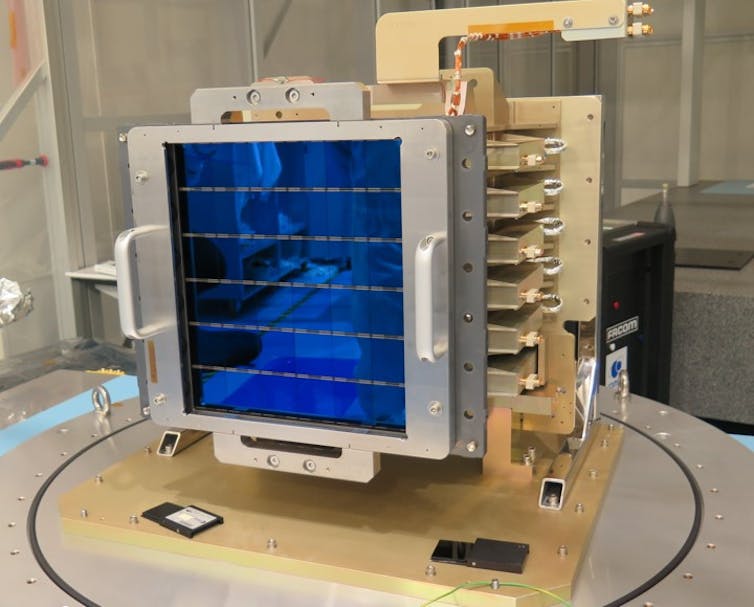

Parlons maintenant des « yeux » d’Euclid, deux instruments installés au foyer d’un télescope d’1,2 m de diamètre. Le premier (appelé VIS) sera sensible à la lumière visible (avec une belle lampe d’étalonnage « made in Orsay » !), tandis que le second (appelé NISP, conçu et réalisé sous responsabilité marseillaise) observera dans l’infrarouge proche.

Ces instruments cumuleront un tel nombre de détecteurs que le plan focal – la zone sensible à la lumière située au foyer – sera couvert par 64 millions de pixels pour l’infrarouge (16 détecteurs de 2 000 × 2 000 pixels) et par environ 604 millions de pixels pour le visible (36 détecteurs de 4 096 × 4 096 pixels). Un record pour l’imagerie dans le secteur spatial (le satellite européen Gaia a embarqué plus de pixels, mais utilisés différemment, notamment en spectroscopie) ! Les deux instruments auront un champ visuel instantané exceptionnellement large : de l’ordre de 0,5 degré carré, à peu près équivalent à la surface angulaire couverte par deux pleines Lune… et environ 160 fois plus grand que le champ visuel de Hubble !

NISP est développé sous responsabilité française, et notre pays contribue aussi largement à VIS. Dans les deux cas, l’agence spatiale française (CNES) joue un rôle majeur aux côtés des organismes nationaux, que sont le CNRS et le CEA, et des universités, pour mener à terme la complexe tâche de concevoir, tester et utiliser ces instruments uniques – un travail appelé « segment vol ».

Le traitement des données d’Euclid représentera un défi plus grand encore que celui de Planck. À tel point que le centre de calcul du CNRS de Lyon – principalement utilisé en physique des particules pour le LHC, le grand accélérateur du CERN – a été sélectionné. Ce centre (appelé « CC-IN2P3 », ou « centre de calcul de l’Institut national de physique nucléaire et de physique des particules ») décuple actuellement ses capacités de traitement et de stockage, afin d’être paré à recevoir les données et les programmes de traitement d’Euclid.

En 2017, soit à l’époque environ cinq ans avant le lancement prévu, nous avions testé la première version du traitement complet des données, lors de ce qu’on appelle des « défis scientifiques » (scientific challenges). Plus précisément, nous testons l’ensemble de la chaîne de programmes informatiques (le pipeline). Cette suite fort complexe de programmes reçoit (à son entrée) les données des instruments, et doit délivrer (à sa sortie) des images étalonnées, exemptes d’effets instrumentaux, ainsi que des catalogues de galaxies incluant la photométrie (flux lumineux dans plusieurs couleurs simultanément), l’identification des étoiles et des galaxies, l’estimation du redshift et celle du cisaillement gravitationnel, la mesure des fonctions de corrélation des galaxies.

Bien entendu, nous ne disposons pas encore des données « réelles », celles des instruments observant depuis l’espace. Nous utilisons donc en attendant des simulations numériques dernier cri de notre Univers : galaxies, étoiles, matière noire, énergie sombre, tout y est (ou presque) ! Ce ciel numérique est alors passé dans un simulateur d’instrument, un programme informatique faisant « comme si » on effectuait une observation. Du bruit, des parasites, des effets instrumentaux (optiques, électroniques, environnement spatial) sont donc ajoutés de façon réaliste. Enfin, ces données simulées sont présentées à notre pipeline, et nous regardons s’il réagit comme nous l’attendions (s’il ne plante pas, évidemment…).

Ce traitement ultra-poussé des données – appelé « segment sol » – mobilise quasiment autant de ressources humaines et matérielles que la construction des instruments eux-mêmes. En cosmologie de précision, la recherche des très faibles biais ou effets indésirables dans les données – primordiale si l’on veut obtenir des résultats robustes – est en effet devenue un « sport international ». L’Europe en général, et la France en particulier, s’y révèlent brillantes.

En tant que responsables d’une part importante du traitement (pour ce qui me concerne : la fusion des données des instruments VIS et NISP, pour extraire les flux de milliards de galaxies et séparer les étoiles des galaxies), nous accompagnons ces tests avec une excitation mêlée de crainte. De l’excitation, car, depuis des mois, nous voyons s’échafauder une grande complexité et nous observons pour la première fois son fonctionnement complet. De la crainte, car nous redoutons des blocages, des cafouillages, des bugs, de mauvaises interfaces… qui ne manquent pas de se manifester, malgré les procédures exigeantes mises en place.

Un exemple de problème « bête » découvert alors : notre programme « plantait » (s’interrompait à cause d’erreurs) car l’un des fichiers en entrée (fourni par d’autres collègues) n’avait pas du tout le format attendu. Malgré nos tests, nous n’avions pas anticipé que l’information que nous attendions dans ce fichier était au final dupliquée… des dizaines de fois (nous n’avions prévu qu’une courte série de valeurs) ! Avec ce genre de préparation, nous serons prêts à recevoir la déferlante du flot de données, une fois Euclid en vol. En 2019, nous avons pour la première fois réalisé un test complet à partir des simulations de l’univers parmi les plus précises, intégrées dans les simulateurs d’instruments. Ces données brutes simulées ont traversé avec succès toute la série de programmes. Le chemin vers le pipeline final est encore long, jalonné de bilans réguliers – appelés « revues », une sorte d’examen critique de nos productions par de nombreux experts – de réunions, et de sueurs froides, mais aussi de joies !

L’ouvrage est paru aux Éditions Dunod. Éditions Dunod

L’ouvrage est paru aux Éditions Dunod. Éditions Dunod

Donnons-nous rendez-vous pour le lancement d’Euclid en 2022, puis quasiment chaque année ensuite pour des résultats intermédiaires, et vers 2028 pour découvrir les résultats finaux d’Euclid sur le secteur sombre de l’Univers !![]()

Hervé Dole, Professeur (astrophysique et physique) - Institut d'Astrophysique Spatiale (CNRS & Univ. Paris-Saclay), Université Paris-Saclay

Cet article est republié à partir de The Conversation sous licence Creative Commons. Lire l’article original.